Conheça 5 benefícios ao investir em Inteligência Artificial

Alguns pensam que a Inteligência Artificial chega para substituir a mão de obra humana. Já outros acreditam que os efeitos da tecnologia podem potencializar o trabalho de profissionais das diversas áreas do conhecimento.

Utilizar ferramentas vinculadas à Inteligência Artificial não significa, necessariamente, abdicar do elemento humano em todos os processos. Muito pelo contrário. Para serem utilizadas de forma objetiva, as ferramentas de IA necessitam do julgamento e da ação humana.

Um dos grandes braços da Inteligência Artificial é o Aprendizado de Máquina - ou Machine Learning. Neste campo, existe a possibilidade de uma máquina ser programada de forma a aprender com suas próprias experiências, atualizando-se de maneira autônoma.

É fato que a automação tem se espalhado por diversos campos da nossa vida. O que vale é entender quais são as aplicações das ferramentas e no que cada uma dessas conquistas pode agregar no cotidiano do mundo corporativo.

Mas, afinal, quais são as vantagens de investir em Inteligência Artificial?

Uma das grandes vantagens em investir em Inteligência Artificial e ferramentas de automação é tornar os processos repetitivos mais baratos e isenta-los de falhas. Neste caso, a Inteligência Artificial pode ser facilmente aplicada para administrar bancos de dado, gerenciar recursos humanos e cuidar da segurança das informações da empresa.

O grande core business deste setor é a personalização. Os serviços personalizados são uma característica do mundo digital. O regime de inovações incentiva as empresas a reaverem seus modelos constantemente. E, diante dessa rotina de aprimoramento, personalizar os serviços é uma grande aposta para melhorar a experiência do usuário progressivamente.

Dentre as principais vantagens de se investir em Inteligência Artificial estão a possibilidade de automatizar o aprendizado do seu negócio; robotizar a tomada de decisões; dispor de informações mais confiáveis e prezar pelo aumento de eficiência.

Abaixo vamos pontuar cinco benefícios que sua empresa pode conquistar ao investir em Inteligência Artificial. Confira:

Redução de Custos

Um estudo feito pela Tata Consultancy Services (TCS), especializada em consultoria e serviços de TI, mostrou que as empresas que conquistaram maior ganho de receita (tendo aumento de 16%, em média) foram aquelas que investiram pelo menos cinco vezes mais na tecnologia.

No mesmo estudo, 84% das empresas consideraram a Inteligência Artificial como essencial para competir no mercado.

Qualificação da Produção

A Inteligência Artificial oferece a possibilidade das empresas qualificarem o trabalho, otimizando os processos não só em cargos operacionais, mas também nos processos de tomada de decisão dentro da empresa.

Além disso, soluções ligadas à Inteligência Artificial e ao Aprendizado de Máquinas, por exemplo, serão responsáveis por abrir novos postos de trabalho no mercado. E, com isso, criar novos trabalhos e serviços que não tinham demanda no passado.

Relacionamento com o Cliente

As novas conquistas da tecnologia têm sido amplamente usadas para aprimorar o relacionamento com o cliente. A Computação Cognitiva e o Aprendizado de Máquina, por exemplo, têm possibilitado o atendimento ao cliente com o uso de robôs e o monitoramento em tempo real das interações em diferentes canais.

O uso de robôs e chatbots é um dos exemplos das novas possibilidades que os avanços tecnológicos oferecem. Guiar a navegação do usuário através de um robô programado, por exemplo, é uma das ações que podem ser executadas graças à Inteligência Artificial.

Vendas e Marketing

Os avanços obtidos com a IA focam em aprimorar ao máximo a experiência do cliente. Uma vez que o relacionamento e o atendimento ao consumidor melhoram, as vendas também tendem a aumentar.

Investir em Inteligência Artificial e na automação de processos pode ter um impacto decisivo sobre as vendas e o marketing em volta da empresa. Prezar pelo conforto e praticidade dos serviços são importantes formas de fidelizar o consumidor e buscar a personalização do atendimento.

Segurança dos dados em TI

Dentro das empresas, os setores de TI frequentemente são os que mais adotam soluções envolvendo a Inteligência Artificial, sobretudo, por questões de segurança. O desenvolvimento de sistemas cognitivos e a programação atrelada à Inteligência Artificial têm oferecido um suporte mais convincente em questão de segurança.

Ao investir em Inteligência Artificial, a estratégia de TI da empresa deve mudar. Com um monitoramento efetivo dos dados e a garantia da segurança das informações, a equipe de trabalho pode se voltar às decisões e ações mais estratégicas dentro da empresa.

A ADTsys aposta na Inteligência Artificial!

As ferramentas vinculadas à Inteligência Artificial conseguem analisar dados em grande escala, identificar padrões, tendências e formular, de maneira automática, soluções com velocidade e precisão.

Conheça os serviços de quem é especializado em soluções de Inteligência Artificial e automação de sistemas. Entre em contato com os especialistas da ADTsys.

Já conhece o NOC 24/7? Saiba como a primeira operação cloud com I.A. pode ajudar a sua empresa!

Cloud Computing: benefícios para pequenas e médias empresas

Cloud Computing: benefícios para pequenas e médias empresas: Descubra como uma tecnologia acessível e que está se tornando cada vez mais difundida, o Cloud Computing conta com diversos serviços de qualidade e fornecedores que ajudam tanto profissionais da área de TI, usuários comuns e empresas de todos os portes. Despontando

Considerada por diversos especialistas da área como a tecnologia que impulsionará a próxima geração, tem como base ser capaz de transformar as operações empresariais, tornando-as mais baratas, ágeis, portáteis e seguras para os seus usuários, influenciando na acessibilidade e na produtividade dos que já utilizam o Cloud Computing.

As características que fazem com que esta solução se aplique de forma bastante acertiva no cenário empresarial são a capacidade de virtualização, de trabalho remoto e da utilização, juntamente com ferramentas de análise e validação. Outro aspecto que faz do Cloud Computing benéfico para pequenas e médias empresas é a economia em relação ao investimento com infraestrutura própria - os servidores e computadores ficam disponíveis remotamente para o uso dos funcionários.

Cloud Computing: Quais os benefícios para pequenas e médias empresas?

As soluções que envolvem a computação em nuvem trazem também diversos benefícios para as empresas que a adotam, como: a capacidade de integrar sistemas remotamente, a disponibilidade (também de forma remota) para os funcionários das aplicações utilizadas pela empresa e a facilidade e escalabilidade dos serviços utilizados.

Abaixo, destacamos alguns pontos importantes:

Economia

Não é a toa que esse tópico vem em primeiro lugar nos pontos importantes para a aplicação do Cloud Computing nas pequenas e médias empresas: o investimento tem que ter algum retorno, uma vez que a economia e a redução de custos são sempre procurados no ambiente empresarial.

A redução de custos com hardware e infraestrutura é um dos principais fatores que influenciam a adoção da computação em nuvem, sendo que a maioria dos provedores que fornecem esse tipo de serviço tem a sua cobrança feita a partir do que é utilizado - ao final do mês, você só paga o que utilizou.

Também deve-se citar o aumento no foco e na produtividade da empresa, uma vez que uma migração bem feita de dados e das aplicações para a nuvem faz com que tarefas de rotina e processos que demandam tempo sejam feitos diretamente pelo provedor do Cloud.

Portabilidade e Acessibilidade

O cenário atual da internet faz com que a capacidade de acessar seus dados de qualquer lugar seja mandatório, sendo benéfico tanto para o mundo coorporativo quanto para os seus funcionários. Limitar a operação para os dias úteis e aos horários comercias está na contramão do mundo digital, onde a informação fica disponível a qualquer hora.

A acessibilidade dos dados é outro ponto importante, uma vez que os dispositivos móveis estão se equiparando a computadores e desktops, facilitando o transporte e a locomoção. Acessar os dados de qualquer lugar, com a confiabilidade na estrutura da empresa é um ponto importante para os seus colaboradores.

Segurança de Dados

A segurança dos dados é um tópico bastante discutido, inclusive definindo a longevidade de um negócio. Ter os seus dados e os dados dos seus clientes seguros é o primordial para fidelizar e manter a sua base de usuários.

Sendo assim, pode-se dizer que o Cloud Computing é um dos serviços que mais investem em segurança dos dados, uma vez que garantir essa característica é essencial para manter seus usuários ativos e confiantes.

Com o avanço da tecnologia e do serviço, o desenvolvimento de técnicas modernas como criptografia, certificados de segurança, backups dos dados e versionamento, dentre outros, são algumas das formas que os provedores de Cloud Computing lidam com a segurança, tendo times dos melhores especialistas trabalhando diariamente.

Confie nos melhores

A ADTsys se destaca pelo amplo portfólio de serviços e Cloud Computing, com ampla experiência no mercado e oferecendo soluções inteligentes e suporte para toda a estrutura de TI.

Entre em contato com o nosso time de especialistas!

Já conhece o NOC 24/7? Saiba como a primeira operação cloud com I.A. pode ajudar a sua empresa!

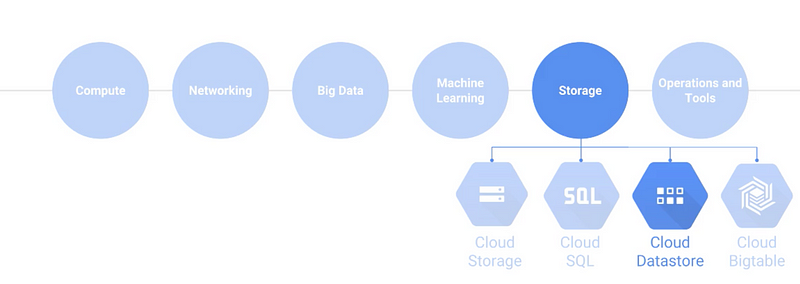

Opções de Storage no Google Cloud Platform

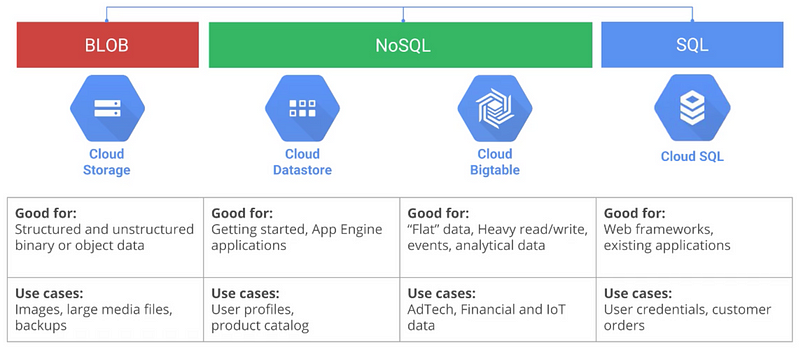

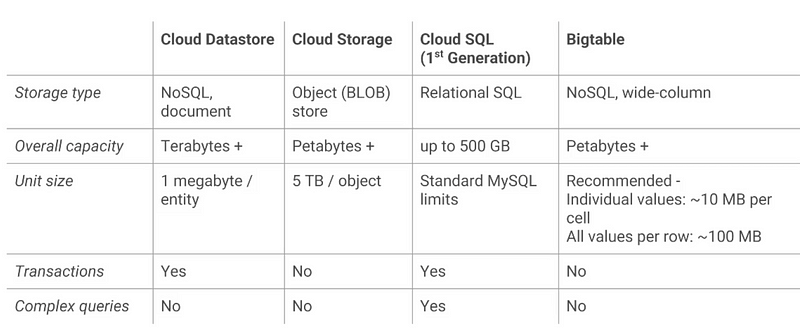

Existem diferentes opções de Storage dentro da plataforma do Google - e nós já falamos sobre o Google Cloud Datastore, lembra? Hoje, nosso foco vão ser as outras opções, incluindo o Google Cloud Storage, Bigtable e Cloud SQL.

Ao final do artigo, você vai saber qual das opções de Storage é a mais indicada para cada caso de uso, lembrando que todas as opções disponibilizadas pelo Google são custo efetivas, seguras, confiáveis e virtualmente ilimitadas. Vamos lá?

Google Cloud Storage

Opções de Storage do Google Cloud

O GCS permite que você utilize a infraestrutura para armazenar dados na nuvem com garantia de 99.999999999% contra perda, “eleven nine reliability”. Seus dados estarão disponíveis quase que em tempo integral.

Uma forma de entender é pensar que armazenando 10 mil objetos no GCS, você vai perder um a cada 10 milhões de anos. Ele também é de alta disponibilidade, extremamente rápido e virtualmente ilimitado.

Tecnicamente, trata-se de uma opção de Storage do tipo BLOB, ou seja, você pode armazenar qualquer dado, como arquivos de texto, imagens, vídeos — qualquer coisa mesmo. Apesar disso, é importante lembrar que o GCS não é um sistema de arquivos, como estamos habituados a visualizar - existem até ferramentas para você ter esta visão, caso queira.

O Google Cloud Storage precisa de baixa administração, e não é necessário fazer o capacity planning, nem o pagamento upfront. Você não tem limite de dados e o armazenamento é escalável e seguro, porque eles são automaticamente encriptados em estado de rest e durante o in-flight. Quando gravada, sua informação é replicada em diversos servidores dentro de múltiplas zonas, garantindo durabilidade.

O primeiro passo para utilizar essa, que é uma das opções de Storage, é criar um objeto chamado bucket. Você pode fazer upload de informações para ele e, no momento da criação, definir em qual região ou regiões este bucket vai estar localizado.

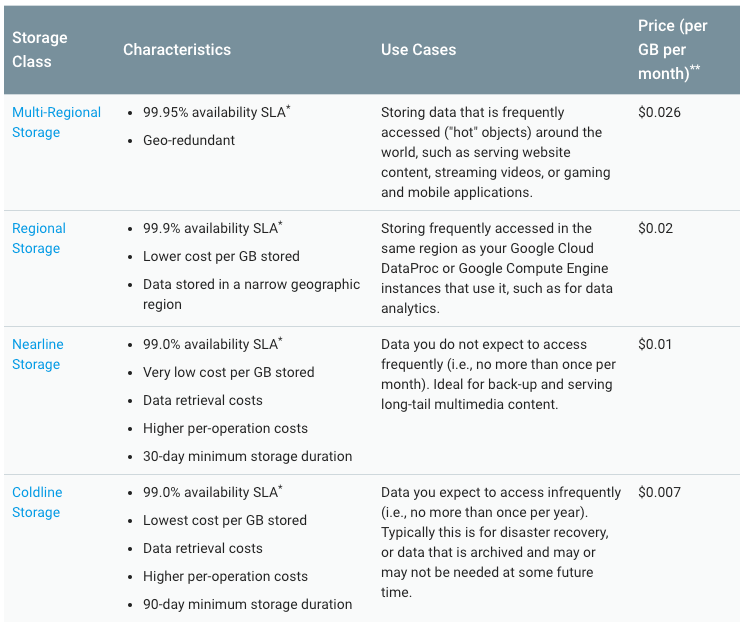

Existem diferentes categorias para o Google Cloud Storage, cada uma para um caso de uso específico, e todas são administradas pelas mesmas ferramentas e APIs.

Standart Storage

Esta, que é uma das opções de Storage, pode ser utilizada em uma (99.9% de disponibilidade) ou múltiplas regiões (99.95%). Use o storage regional quando o o bucket for acessado frequentemente por seus componentes na mesma região, como o Computer Engine.

Nearline/Coldline Storage

Utilizado para dados que não são frequentemente utilizados, o custo dessa opção de Storage é. geralmente, bem menor, assim como a forma de cobrança muda.

Comparação entre os modelos possíveis.

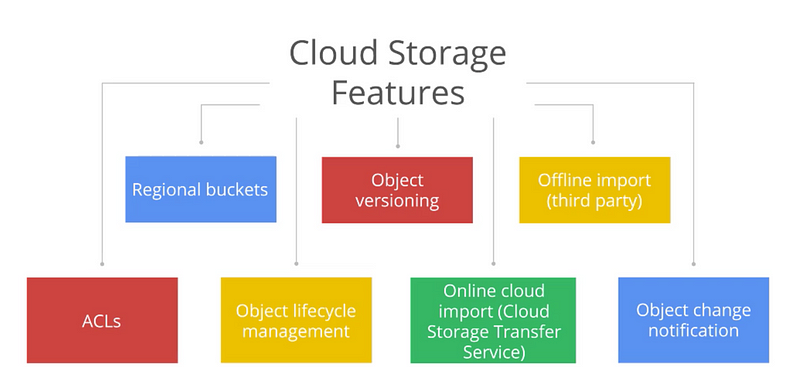

Os buckets suportam controle que, quando ligado, cria uma nova versão do objeto quando ele é alterado. Você pode fazer importações offline para carregar dos seus dispositivos para o Cloud Storage, e aplicar facilmente quem pode acessar seus buckets e objetos (por padrão somente o owner tem acesso), como por exemplo conteúdo disponível para web.

Também é possível definir ciclo de vida de objetos, como transferir os antigos para o Cold Storage. Existem ferramentas para movimentar os dados de um bucket para outro e, por final, podemos criar serviços de notificação para alterações seus buckets, como novo uploads.

Funcionalidades do Cloud Storage

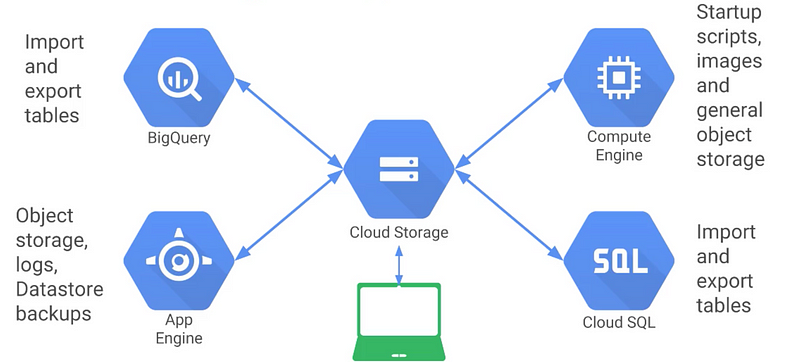

O Google Cloud Storage, normalmente, é o local onde ficam as informações que serão enviadas para a nuvem. Você pode utilizá-lo para importar scripts, logs, backups e imagens de máquinas. Como integra com Cloud SQL e Compute Engine, viabiliza, também, uma maneira de armazenar scripts de configuração.

Exemplos de utilização do Cloud Storage

Google Cloud Bigtable

O Google Cloud Bigtable é outra das opções de Storage e um banco de dados NoSQL, NoOps. Conhecido como wide-storage, cada objeto que você salva tem uma key, e, associado a ela, podem existir várias colunas de dados.

Ele é otimizado para trabalhar com escritas em velocidades extremamente altas e para grandes quantidades de dados - estamos falando de eventualmente petabytes de informações salvas no Bigtable.

O Google Cloud Bigtable pode ser acessado utilizando a mesma API do HBase, ferramenta popular de quem utiliza Hadoop, o que possibilita uma fácil migração de jobs para o GCP. Como todos os serviços administrados pelo Google, é seguro e oferece criptografia de dados, rest e in-flight, assim como é replicado em diferentes zonas para redundância. Também é possível controlar os acessos utilizando ACL. Atualmente, o Bigtable é utilizado por serviços como o Gmail.

Normalmente, o Bigtable é utilizado por clientes quando eles necessitam armazenar uma grande quantidade de dados de forma estruturada, maior que um terabyte.

O Bigtable foi desenvolvido para tratar volumes extremos de dados com velocidade. Você pode ler as informações armazenadas nele utilizando uma API utilizando Java ou uma interface web para mostrar informações analíticas.

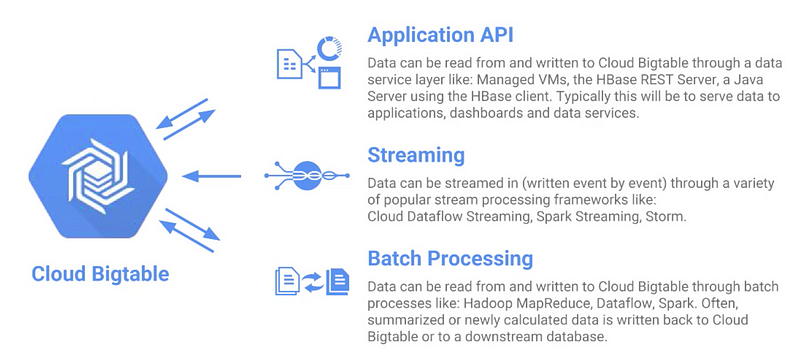

Patterns de integração com o Bigtable

Dados podem ser transmitidos em tempo real com o Google Cloud Dataflow, assim como outros frameworks, como o Spark Streaming, que também oferece esta compatibilidade, além de ser escritos e lidos em batch com ferramentas como o Cloud Dataflow, Hadoop MapReduze ou Spark.

O conector do Cloud Dataflow com o Bigtable torna possível a utilização para operações como batch e streaming. Esta SDK está desenvolvida em Java e foi construída no topo do client de HBase. Você também pode conectar suas IDEs localmente ao Bigtable para visualizar as informações.

Google Cloud SQL também é uma das opções de Storage

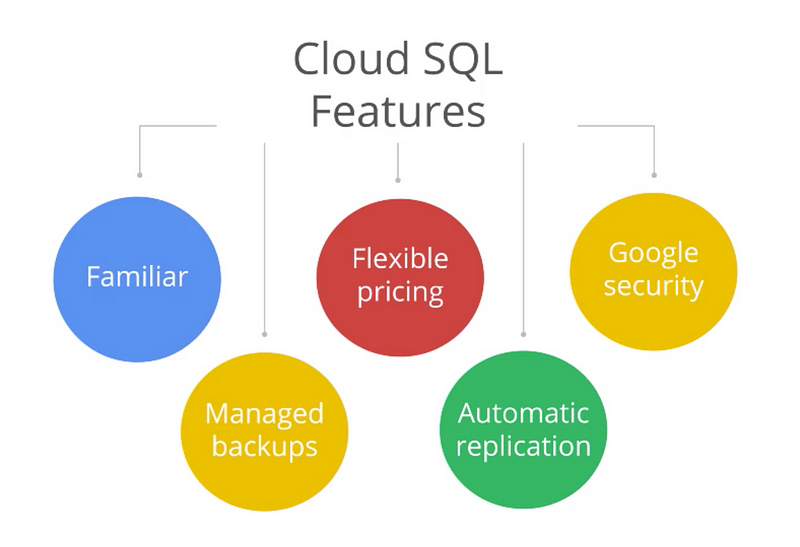

Este é o banco de dados MySQL administrado pelo Google na nuvem. NoOps, onde todas as tarefas típicas de administração como backups e aplicação de patch, são feitas automaticamente. Você pode configurar uma réplica com o click de um botão.

Funcionalidades padrão do Google Cloud SQL

Quando você cria um Cloud SQL, define quanto de espaço, CPU e RAM precisa. Só serão cobrados a quantidade de recursos que alocados, por isso, o ideal é começar pequeno, pois é fácil escalar em um segundo momento.

Você pode criar um CloudSQL usando o Cloud Console, Linhas de Comando ou via REST, e ele é ideal para salvar dados em bancos de dados relacionais em suas aplicações cloud. As informações são encriptadas quando os dados são salvos nas tabelas, arquivos ou backups e quando são movidos pela rede.

Toda instância de Cloud SQL tem um firewall junto que habilita o administrador controlar os acessos do seu banco de dados.

Ele pode ser escalado horizontal e verticalmente, como definir 16 núcleos de processador e mais de 100gb de RAM, além de configurar réplicas. Se você conhece o MySQL, já estará habituado com a sua facilidade de utilização.

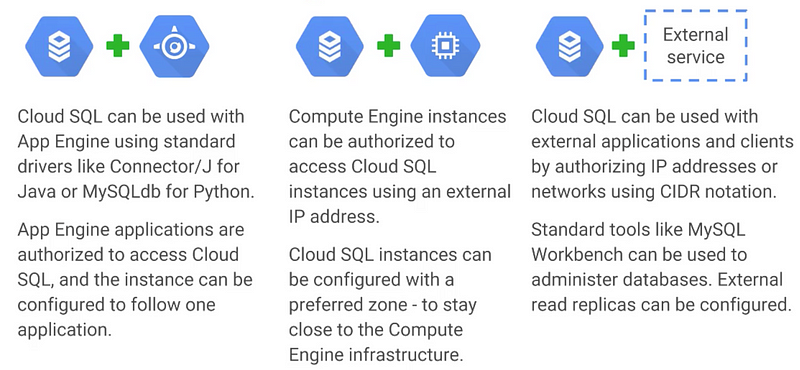

Formas de integração com o Cloud SQL

Os serviços que rodam no App Engine são autorizados automaticamente para conectar via SDK. Você pode autorizar outros serviços, como o Compute Engine e sua máquina através da configuração de firewall.

Funcionalidades de cada opção

Como vimos, são várias as opções de Storage no Google Cloud Platform. Já sabe qual é ideal para a sua demanda? Continue acompanhando nossas publicações para saber mais sobre estes e outros tópicos. Críticas, dúvidas sobre as opções de Storage e sugestões são bem-vindas nos comentários. Até a próxima.

ADTsys Cloud Computing

Já conhece o NOC 24/7? Saiba como a primeira operação cloud com I.A. pode ajudar a sua empresa!

E-book: NOC 24/7 – Entenda como funciona a primeira operação Cloud baseada em Inteligência Artificial

NOC 24/7 - Centro de Operações de rede - é um local ou serviço onde se centraliza o monitoramento e operações de um ou mais ambientes de rede de TI. Com ele, é possível obter mais produtividade e efetividade, com uma maior satisfação dos usuários, já que ele permite uma automação efetiva da sua operação cloud.

Pensando nisso, preparamos um e-book que permite com que você entenda como o NOC 24/7 pode ajudar a sua empresa!

Baixe agora o e-book NOC 24/7 – Entenda como funciona a primeira operação Cloud baseada em Inteligência Artificial e aprenda a otimizar a sua operação cloud!

Inteligência Artificial nas Operações de TI

A área de Tecnologia da Informação (TI) representa um setor fundamental dentro de uma empresa ou organização. Atualmente, é o principal segmento responsável por codificar e armazenar dados internos, por exemplo.

A Inteligência Artificial, enquanto um desdobramento das Ciências da Computação, apresentou aos programadores e desenvolvedores a oportunidade de contar com a capacidade das máquinas.

De acordo com a IA, diferentes níveis de automatização agora são capazes de simular as atividades humanas. As possibilidades oferecidas pela Inteligência Artificial vêm modificando por completo a tarefa de operar sistemas em diversos segmentos, sobretudo, no campo da Tecnologia da Informação.

Inteligência Artificial: a tendência no universo da TI

As diversas aplicações da Inteligência Artificial possibilitam uma aplicação em larga escala nos diversos segmentos da indústria. As ferramentas de IA conseguem interagir com um internauta, registrar dados, proceder com análises e outros alertas, entre outras funções.

Todo o crescimento e importância que o setor de TI adquiriu dentro das organizações fortalece as ferramentas de Inteligência Artificial como uma grande tendência para o universo digital daqui para frente.

Apostar nas soluções atreladas à Inteligência Artificial e TI, atualmente, pode ser uma tentativa de otimizar a gestão dos negócios e se manter na dianteira de um mercado competitivo e imediatista, que por sua vez retrata a evolução e as conquistas da sociedade.

O crescimento do cloud computing, enquanto braço da IA e ferramenta de armazenamento e compartilhamento de dados, também traz novas perspectivas à gestão empresarial.

A segurança e privacidade dos dados, a rapidez no compartilhamento e a capacidade de armazenagem são alguns dos pontos positivos a serem destacados na tecnologia em nuvem.

Gerenciar a infraestrutura de um projeto ou sistema usando cloud computing é a melhor forma de automatizar os processos. O NOC CLOUD 24/7, desenvolvido pela ADTsys, pode garantir a estabilidade e a automação de todos os ambientes digitais dos clientes.

O monitoramento é feito 24 horas por dia, sete dias por semana, e com controle da gestão, operação e monitoramento. Conheça os planos!

Baixe o e-Book e saiba como o NOC 24/7, a primeira operação cloud com I.A., pode ajudar a sua empresa!

Google App Engine e Cloud Datastore

O App Engine é categorizado como um PaaS (Platform as a Service) que faz com que o deploy de suas aplicações sejam executados de forma simples. Já o Cloud Datastore é um banco NoSQL e NoOps totalmente administrado que pode ser utilizado com o App Engine.

Google App Engine

O Google App Engine é uma das opções de recursos de máquinas para rodar suas aplicações e uma plataforma para construir aplicações web de forma escalável, assim como seus serviços.

Com o Google App Engine você faz o deploy da aplicação com um simples comando e ele toma conta de todos os detalhes que envolvem este deploy. Imagine um bug fix: o App Engine inicia uma nova versão do programa e para as antigas quando você subir uma nova versão.

Pico de acesso? O Google App Engine vai automaticamente criar aplicações para você assim como desligá-las quando você tiver poucos acessos.

Não existem Load Balancers para ser configurados, patches instalados. Aqui o objetivo é focar no seu código e respectiva aplicação, e a plataforma vai criar do resto (NoOps lembra?). Ela vai cuidar do hardware, rede, load balancer, monitoramento e escalabilidade necessárias para manter seu projeto rodando. Atualmente você pode utilizar modelos em Java, Python, PHP e Go ou criar os seus runtimes.

Existem grandes empresas que rodam utilizando o App Engine, como por exemplo o Snapchat. "O App Engine nos possibilita focar no desenvolvimento da aplicação. Nós não teríamos chegado até aqui sem o suporte que o App Engine nos deu", disse Bobby Murphy

Imaginem a complexidade para tratar a infraestutura e o custo de equipe para um software como utilizando o IaaS. Este é só um exemplo de como o NoOps pode transformar a realidade de empresas e de uma startup.

Atualmente existem duas formas de se trabalhar com o App Engine chamadas de Standard e Flexible. Vamos estudá-las a seguir.

App Engine Standard Environment

Estes containers estarão rodando na infraestrutura do Google, fora do Compute Engine. Neste formato existem runtimes pré definidas já disponibilizadas para utilização com Java , Python, PHP e Go.

Uma das vantagens de utilizar este modelo é a sua habilidade em escalar rapidamente. O próprio Google App Engine monitora sua app e o seu tráfego e vai ligar e desligar instâncias conforme a necessidade.

O Google App Engine inicia runtimes em millisegundos, o que torna possível que a aplicação seja “desligada” quando você não tem usuários, entrando no free-tier de custo zero. Existem SDKs para cada uma das linguagens suportadas e é possível rodar este SDK localmente, assim como existem ferramentas de deploy para novas versões de aplicação.

Como este modelo faz com que o Google App Engine rode em ambientes em sandboxes, existem certas premissas que sua aplicação deve respeitar. Algumas delas são limitações de softwares que você pode instalar, versionamento de idiomas e o fato de não poder escrever no file system. A autenticação com os sandboxes pode ser feita utilizando-se Google Accounts ou contas em seus domínios.

Cada projeto tem um ambiente de Google App Engine e as aplicações neste ambiente podem ser divididas em serviços, onde cada serviço pode ser atualizado de forma separada e cada serviço pode rodar em um ou mais containers.

Podemos versionar serviços e rodar versões diferentes simultaneamente especificando a porcentegem de distribuição de requisições (A/B testing).

Dentro do Google App Engine podemos integrar facilmente com outros serviços como o Memcache, Chron ou de busca com o Cloud Data Store.

App Engine Flexible Environment

Como o próprio nome diz, aqui temos a flexibilidade. O Google entrega esta flexibilidade através de containers Docker onde você pode configurar exatamente o que precisa para sua aplicação.

Existem alguns containers já pré-configurados que o Google disponibiliza como Java 8 e Python. Vamos dizer que você queira desenvolver o software usando C# é possível configurar um container que utilize as bibliotecas necessárias. Lembrando que suas aplicações ainda serão publicadas em um modelo NoOps que toma conta de toda a escalabilidade, monitoramento e por aí vai.

O deploy é feito de forma ligeiramente diferente do standart. Os containers Docker rodam no Compute Engine, ou seja, são criadas máquinas virtuais e estas serão cobradas no modelo do CE. Os containers distribuídos pelo Google tem a mesma configuração dos serviços do standart, incluindo também as mesmas SKDs.

Caso sua aplicação utilize padrões orientados a serviço, é possível rodar os dois modos simultaneamente de acordo com a necessidade de seus serviços.

Google Cloud Endpoints

Um assunto que também vamos falar rapidamente aqui é o GCE. Com este serviço você pode criar APIs seguindo o padrão REST e assim serão documentados exatamente como são os do Google. Através de anotações no código você possibilita algo como o Swagger.

Estes endpoints também simplificam a integração com autenticação OAuth 2 em seus próprios serviços. Atualmente eles podem ser consumidos por serviços que foram desenvolvidos em Java e Python, assim como em aplicações iOS, Android e Web.

Google Cloud Datastore

No SQL altamente escalável para suas aplicações, administrado pelo Google e que é ideal para salvar dados de suas aplicações que rodam no Google App Engine. Ele é schemaless e utiliza o conceito de entidades e propriedades com seus respectivos valores.

Você pode salvar estas entidades da forma que desejar, sem se preocupar com o schema do banco de dados. Existe a possibilidade de conectar ferramentas de desenvolvimento para simular este db localmente.

Como todo serviço NoOps, você não precisa se preocupar com configuração pois ele vai escalar automaticamente e salvar os dados em zonas múltiplas. Transações ACID, garantindo o estado dos dados entre os containers e free-tier que para os pequenos que não gera custo e integra nativamente com App Engine. Existem ainda APIs para você integrar em suas aplicações.

LAB

Este vai ser bem legal! Vamos usar o AppEngine para rodar uma aplicação chamada Bookshelf. Esta aplicação usa o Google Cloud Datastore para armazenar dados e pode ser inserida no modelo standard do App Engine. Vamos clonar um repositório e fazer o deploy da aplicação, como em um caso real. Ele está disponível neste link.

Já conhece o NOC 24/7? Saiba como a primeira operação cloud com I.A. pode ajudar a sua empresa!

Certificação Google Cloud Architect: Plano de estudos

Certificação Google Cloud Architect: Plano de estudos: Todo o material produzido nos posts tem que ser estudado e os labs executado. E para que isso aconteça precisamos do que temos de mais precioso, o tempo.

Neste post vamos alinhar nossas expectativas e ter uma perspectiva de esforço para a pessoa que já é da área de TI e pretende realizar a prova para Certificação Google Cloud Architect. A ideia é distribuir conteúdo necessário para a prova dividido em cinco semanas.

Como conseguir a Certificação Google Cloud Architect?

Para tentar organizar os posts, vamos dividir a preparação para a Certificação Google Cloud Architect em módulos de especialização e cada um destes módulos com seus tópicos pertinentes.

Os links relacionados ao material já publicado serão atualizados diariamente. Espero que gostem!

Semana 01| C001 Fundamentos do Google Cloud

Nesta semana você irá conhecer a ferramenta, suas funcionalidades básicas e subir suas primeiras aplicações para alcançar a Certificação Google Cloud Architect.

- Introdução ao Google Cloud Platform.

- Começando com o Google Cloud Platform.

- Google App Engine e Cloud Datastore.

- Opções de storage para o GCP.

- Google Containter Engine.

- Google Compute Engine e Networking.

- Big Data e Machine Learning.

Semana 02| C002 Infraestrutura Cloud

Uma semana para aprender sobre Infraestrutura dentro da plataforma. Vamos durante este estudo implementar componentes de estrutura de rede, máquinas virtuais e serviços.

O estudo do Google Cloud Shell será aprofundado e vamos começar a entender o trabalho dentro do Google Cloud Architect e trabalhar para desenvolver a intuição de como escolher as melhores práticas para criar e e configurar máquinas virtuais com Cloud Virtual Networks (CVN), Projetos, Redes, Subredes, IPs, Rotas e regras de Firewall.

- Introdução do Google Cloud Platform Infrastructure.

- Redes Virtuais.

- Máquinas Virtuais.

Semana 03| C003 Serviços Cloud

Entendendo infraestrutura e plataforma de serviços entregues pela GCP. Componentes de infraestruturas, sistemas e aplicações. Deploy de segurança com redes interconectadas e keys customizadas, assim como segurança e regras de acesso. Para finalizar, quotas, billing e monitoramento de recursos.

- Cloud IAM.

- Serviços de Data Storage.

- Administração de recursos.

- Monitoramento.

Semana 04| C004 Elastic Cloud: Escalando e Automatizando

Vamos estudar como funciona o Google Cloud Architect e como escalamos máquinas e o que podemos fazer para automatizá-las.

- Interconectando redes.

- Load Balancing.

- Autoscaling.

- Automação de Infraestrutura usando o Cloud API.

- Automação de Infraestrutura usando o Deployment Manager.

- Serviços NoOps.

Semana 05| C005 Elastic Cloud: Containers e Serviços

Como aprimorar as aplicações para aumentar a escalabilidade e sua facilidade de manutenção. Vamos conhecer serviços como o Google Cloud Pub/Sub e o Cloud Functions para deixar suas aplicações ainda mais eficientes.

- Serviços de infraestrutura

- Serviços de desenvolvimento

- Containers

Após concluído o estudo de todo o material vamos ter conhecimento de todos os assuntos que são tratados para a prova de Certificação Google Cloud Architect. É importante que antes de agendar a data, o aluno pratique em ferramentas existentes que simulam seu conhecimento no conteúdo.

Agora, o tempo. Quanto tempo estudar para conseguir cobrir todo este material e quem sabe estudar a fundo para conseguir passar na prova. A estimativa é de 10–12 horas de estudos semanais para cobrir o conteúdo.

Para reproduzir é outra história… vai depender do conhecimento prévio de cada um assim como sua dedicação e possibilidades.

Links úteis para estudos complementares:

• Labs Beginner

• Labs Expert

Agora, você já sabe como se preparar para a Certificação Google Cloud Architect. Então, é hora de entender como o NOC 24/7, a primeira operação cloud com I.A., pode ajudar a sua empresa!

Big Data e Analytics: Azure, AWS ou Google, qual o ideal?

Olá, pessoal!

Novamente, estou aqui com mais um artigo para tentar ajudá-los na escolha de qual provedor cloud utilizar para criar esse ambiente de Big Data e Analytics.

Escolher o provedor de cloud pode ser uma tarefa um pouco assustadora, pois temos três provedores gigantes: Azure, AWS e Google; cada tem um cardápio bem diverso de serviços, deixando essa escolha um pouco complexa. E como as empresas estão cada vez mais migrando suas aplicações para cloud, é extremamente importante entendermos como esses sistemas vão operar nesse formato.

Big Data e Analytics

A cloud vem transformando a maneira como as empresas estão pensando sobre seus dados. A análise avançada dos dados conduz à tomada de decisões de negócios mais rápida e precisa, trazendo, assim, uma abertura de novas oportunidades de negócios para a empresa.

Microsoft Azure

A Microsoft Azure oferece um conjunto de produtos para Big Data e Analytics, chamado Cortana Intelligence Suite. Essa suíte traz o HDInsight, plataforma que vem com Hadoop, Spark, Apache Storm e Apache HBase. Ela tem um nível padrão e premium, esta última incluindo a opção de executar RServer, solução empresarial da Microsoft para construção e execução de modelos R em escala.

A precificação da Microsoft Azure é baseada no número e tipo de nós de execução. O tipo de nó governa o número de núcleos, memória RAM e espaço em disco disponível em cada nó. HDInsight inclui HDFS local e também pode se conectar ao armazenamento blob ou no data lake. Os dados armazenados no HDFS local são voláteis, ou seja, assim que o cluster é desligado os dados serão deletados. Os clusters podem ser criados automaticamente e excluídos utilizando PowerShell e automação dos processos.

Outro serviço bem interessante é o Azure Data Factory, que faz a orquestração dos dados que são utilizados para o pipeline do processamento. O Azure Data Factory pode ler os dados que estão dentro do Microsoft Azure e de fontes externas através do Data Management Gateway, podendo se conectar e consumir dados da infraestrutura on-premise do cliente. O Azure Data Factory traz uma série de atividades que podem ser executadas por agendamento no HDInsight, Azure Machine Learning, data lake e por execuções em lote.

Há, também, o Azure Data Lake Analytic. Esse data lake é um novo tipo de armazenamento de dados em larga escala, utilizando a plataforma serverless e analítica. Ele foi projetado para executar trabalhos de análise em alta escala, sem a necessidade de provisionar ou gerenciar os clusters. As cargas de trabalho são otimizadas para executar no data lake store, uma solução de armazenamento compatível com o HDFS, mas também podem acessar dados em Blob Storage, Banco de Dados e Data Warehouse.

Para processamento de dados em tempo real, o Azure possui o Stream Analytics, que pode processar os dados pelo armazenamento Blob. A linguagem SQL-like é usada para executar consultas e encaminhar para o Azure Machine Learning, onde o mesmo processa em tempo real.

A Azure Machine Learning é uma plataforma para a ciência dos dados, totalmente gerenciado e utilizado para criar e implantar modelos cognitivos e estatísticos. Ele traz uma tela de interface para o usuário e um conjunto de módulos pré-definidos que podem ser usados para construir e executar experiências com os dados. A plataforma vem com uma série de modelos de aprendizagem de máquina pré-definida e inclui a capacidade de executar código em Python & R personalizados.

Em relação aos dashboards, a Microsoft Azure tem o Power BI, que pode consumir dados do Azure e serviços de terceiros, bem como se conectar a fontes de dados on-premise. Os usuários podem escolher, com um conjunto de visualizações incorporadas, criar a sua própria ou selecionar a partir de uma galeria personalizando seu dashboard.

Amazon Web Services (AWS)

A AWS tem, dentro dos serviços para processamento de dados e análise, o AWS Elastic MapReduce (EMR), que são clusters que podem utilizar Hadoop, Spark e a solução da Presto. O EMR faz a criação do cluster com as instâncias EC2 e fornece a integração com uma série de serviços da AWS, incluindo S3 e DynamoDB. A precificação do EMR é baseada em um custo por hora para cada nó mais o preço da instância EC2.

Para reduzir custos, é possível utilizar as instâncias reservadas. Os clusters podem ser criados e excluídos sob demanda para processar trabalhos pontuais ou contínuos, e, geralmente para o cluster ficar disponível, leva, aproximadamente, 10 a 15 minutos, e, assim, iniciar a execução do trabalho.

Há, também, o AWS Data Pipeline, um produto para orquestração de dados que possibilita gerenciar o agendamento, acompanhamento das atividades, bem como qualquer lógica necessária para lidar com cenários de falhas. O AWS Data Pipeline pode ler e gravar dados da maioria dos serviços de armazenamento da AWS, suporta uma gama de atividades de processamento, incluindo EMR, Hive, Pig, e executa comandos em shell Unix/Linux.

Para altas frequências de análises em tempo real, a AWS tem o AWS Kinesis. Nesta aplicação, fontes consumidoras de dados podem enviar dados em tempo real para um fluxo do Kinesis, quando é processado usando a Biblioteca Kinesis Client Library e Connector Library. Dependendo do cenário, é possível conectar o AWS Kinesis a um cluster com Apache Storm.

Há, também, o Amazon Kinesis Firehose, que pode ser utilizado para a ingestão de dados em grande escala, que são enviados para um fluxo de entrega do AWS Kinesis Firehose, e, automaticamente, encaminhados para um serviço como o bucket S3, Redshift ou ElasticSearch, que, por sua vez, suporta a compressão do lado do cliente e criptografia do lado do servidor.

Para análise preditiva, utilizamos o AWS Machine Learning, que torna muito fácil a criação de modelos preditivos, sem a necessidade de aprender algoritmos complexos. Para criar um modelo de usuários, somos guiados pelo processo de seleção e preparação de dados, treinamento e avaliação de modelos por meio de uma interface de usuário baseada em um assistente. Também é possível criar modelos pela AWS SDK. Uma vez formado, ele pode ser usado para criar previsões via API on-line (exemplo: pedido/resposta) ou uma API de lote para processar vários registros de entrada.

Para dar sentido à análise dos dados por meio de dashboards e visualizações, a AWS oferece o QuickSight, pelo qual os painéis podem ser construídos a partir de dados armazenados.

Google Cloud Platform

O Google, inicialmente, traz o Cloud Dataproc, que é totalmente gerenciado por Hadoop e Spark. Ele possui um tempo de 90 segundos (isso é real), impressionante para iniciar ou expandir os clusters do Cloud Dataproc, e é, de longe, o mais rápido dos três fornecedores. O preço é baseado nos custos do Compute Engine, além de um custo adicional por vCPU por minuto. Seu conector é compatível HDFS e está disponível para armazenamento em nuvem no cloud storage, podendo ser usado para armazenar dados que precisar ser utilizados depois que o cluster for desligado.

Não há nenhum suporte embutido para clusters sob demanda. O controle total está disponível através da cli gcloud, API REST ou SDK, podendo, este, ser automatizado, se necessário.

Para o processamento de alta escala e em tempo real, temos o Cloud Dataflow. O Google faz uma abordagem diferente da AWS e Azure: o Cloud Dataflow oferece uma estrutura totalmente programável, disponível para Java e Python, sendo, assim, uma plataforma de computação distribuída. O modelo de programação e SDK foi recentemente apresentado à Fundação Apache e se tornou Apache Beam, que pode usar tanto Cloud Dataflow, bem como Spark para execução do pipeline.

Cloud Dataflow suporta cargas de streaming e de lote. Por padrão, o número de "workers" é pré-definido quando o serviço é criado, embora os "workers" para o lote tenham a opção de auto-escala com base na demanda. O último preço é baseado na CPU agregado, memória e armazenamento consumido, e varia de acordo com o uso de lote ou de streaming que são utilizados pelo "workers".

O Google oferece o Machine Learning como uma plataforma totalmente gerenciada para a utilização dos modelos do Tensorflow. Ele se baseia no Cloud Dataflow para processamento de dados e funcionalidade e Cloud Storage para armazenamento deles. Há, também, o Cloud Datalab, uma ferramenta interativa para insights de dados, que tem como base o Jupyter, e um conjunto de modelos pré-determinados também estão disponíveis.

Em conjunto com o Vision API, é possível detectar características em imagens, tais como texto e logotipos de empresas. Ao adicionar o Speech API, é possível converter áudio para texto em uma variedade de línguas, com APIs de linguagens podendo ser utilizadas para extrair o significado do texto.

Além disso, temos o Google Cloud Prediction API, que se posiciona no meio dessas ferramentas como um middle, permitindo aos usuários criarem modelos categóricos ou de regressão dependendo da natureza do conjunto. Isto, simplesmente, requer que os usuários façam o upload de um conjunto de dados e especifiquem uma coluna de resposta para prever, com o Prediction API fazendo todo o serviço pesado.

E qual é a conclusão?

Cloud para Big Data e Analytics é, claramente, um espaço competitivo. Além da competição, ele está, também, se tornando um componente crítico dos negócios modernos, impulsionando a adoção da cloud pelas empresas.

Todos os três provedores (Azure, AWS e Google) oferecem serviços semelhantes:

- Processamento de Dados;

- Orquestração de Dados;

- Análise de Streaming;

- Machine Learning.

Microsoft Azure

Oferece um conjunto abrangente de produtos analíticos gerenciados. Eles apoiam soluções para Big Data utilizando softwares de código aberto e ao lado de novos produtos analíticos sem servidor, como o Data Lake.

AWS

Certamente, tem todas as bases acima citadas com um sólido conjunto de produtos que atende à maioria das necessidades. Possui alguns pormenores, como modelos pré-determinados de machine learning.

Fornece o que tem de melhor de Big Data e Analytics, com sua gama de serviços, como Dataproc e Dataflow. Tensor Flow tem recebido muita atenção recentemente.

O Google tem um forte conjunto de APIs pré-determinadas, mas carece no item de Dashboards de BI. Não podemos esquecer que ele só processa busca na internet o que demonstra sua qualidade e importância nesse quesito.

Para finalizar, espero ter ajudado com esse artigo para que você possa decidir em qual provedor irá iniciar sua Big Data, Analytics e Machine Learning. Participe nos comentários dando sua opinião, crítica ou sugestão e até a próxima.

Marcelo Franco

Arquiteto de Soluções

Fundamentos do Google Cloud Platform

Google Cloud Platform saiba como tomar as melhores decisões

Você sabe o que é necessário saber para tomar decisões de arquitetura e infraestrutura, utilizando GCP (Google Cloud Platform), assim como a utilização de seus serviços?

No artigo de hoje, vamos nos aprofundar nos tópicos relacionados de forma a descobrir as melhores práticas para utilização:

• Introdução ao Google Cloud Platform

• Começando com o Google Cloud Platform

• Google App Engine e Cloud Datastore

• Opções de storage para o GCP

• Google Containter Engine

• Google Compute Engine e Networking

• Big Data e Machine Learning

Vamos lá?

O que é o Google Cloud Platform (GCP)?

Basicamente, o Google Cloud Platform oferece serviços de infraestrutura para criar máquinas virtuais e suas respectivas configurações de rede. Existem serviços que fazem com que o deploy de uma aplicação seja mais fácil, assim como serviços de Big Data que permitem armazenar quantidades enormes de dados em tempo real.

Utilizando o GCP, você pode facilmente incorporar conceitos de Machine Learning e treinar modelos para tomar decisões de forma rápida, o que, atualmente, é um diferencial para muitas empresas.

Vamos falar sobre a estrutura básica do Google Cloud Platform e como são seus datacenters e estruturas de rede?

Como funciona o Google Cloud Platform (GCP)?

O GCP permite que você rode suas aplicações na mesma infraestrutura em que o Google utiliza seus sistemas. Alguns dos apps mais utilizadas no mundo utilizam esta mesma infraestrutura. Quer ter uma ideia de como isso é imenso? É algo até difícil de imaginar em um primeiro momento: são incríveis um trilhão de buscas feitas anualmente e mais de um bilhão de contas ativas do Gmail.

O ambiente é seguro. Tudo que é armazenado no Google Cloud Platform (GCP) é criptografado em estado de “repouso”, assim como quando se trafega na rede - você não precisa habilitar ou configurar nada. Todos os serviços são pensados com tolerância a falhas e, caso algum problema de hardware aconteça, sempre vão existir sistemas de backup para tomar o seu lugar.

Existem diversos serviços que o GCP disponibiliza como, por exemplo, os de infraestrutura computacional e de dados, big data e machine learning. A missão do Google é organizar toda a informação do mundo e, seguindo este caminho, eles construíram a maior estrutura de datacenters.

Ela fornece poder computacional e de armazenamento, assim como está toda conectada por meio de fibra óptica de alta velocidade. Além dos datacenters, existem, ainda, outros pontos de presença divididos em todo o mundo que também são conectados pelo backbone do Google.

O Google opera com o chamado edge caching, no qual os dados podem ser cacheados em zonas próximas ao usuário para uma melhor performance e redução de custos. Sim, conteúdo distribuído através de edge cache não é cobrado.

Regiões e Zonas

Um pouco de terminologia para definirmos o nosso vocabulário. Os datacenters estão espalhados em várias localizações do mundo, denominadas regiões. O Google tem um datacenter no estado de Iowa, nos EUA, conhecido por US Central 1. Cada região é dividida em um número de zonas. Assim, US Central 1 é dividido em quatro zonas distintas, A, B, C e F.

É possível disponibilizar o deploy de um app em todas as quatro zonas para uma melhor tolerância à falha, e, também, habilitá-lo em uma outra região, assim, caso algum desastre natural aconteça, o seu sistema vai continuar no ar.

Amigos do Meio Ambiente

O Google está comprometido em fazer com que seus datacenters sejam amigos do meio ambiente. Isto é feito, em parte, por sempre inovar e elevar sua capacidade em gerar energia de forma eficiente e em seu ambiente. O Google também investe em formas de gerar energia renovável e todos os seus datacenters não emitem Carbono.

A migração para a nuvem

Não se migra para o cloud porque é mais barato. A nuvem é superior em todas as formas possíveis e imagináveis, e este deveria ser o real motivo. Mesmo assim, ele também é mais barato do que a forma tradicional. Nesse sentido, o Google inova mais uma vez e com seu modelo de preços, e, atualmente, é o mais atrativo do mercado.

Formatos de preço no GCP

Primeiramente, temos o chamado sub-hour billing. Trata-se de uma cobrança feita por minutos e não por horas, como em alguns concorrentes. Colocando em termos práticos, se uma rotina roda 75 minutos, a conta já vai ficar bem mais barata.

Para máquinas que rodam 24/7, existe o sustained-use. Esta modalidade permite que, caso você utilize uma máquina por mais de 25% do mês, a ferramenta automaticamente te dá um desconto para cada minuto a mais. Quanto mais se usa, maior o desconto, que pode chegar a 30% para instâncias que rodam o mês todo - sem pagamento adiantado ou contrato de longo termo.

Finalmente, podemos customizar nossas instâncias com os custom machine types. Estes permitem que você customize a capacidade de CPU e memória para suas máquinas virtuais.

APIs abertas e Open Source

Os clientes devem utilizar nossos serviços porque nos amam, e não porque não podem migrar, afirma o Google. A empresa tem compromisso com código aberto e, atualmente, muitos dos seus produtos utilizam esta mesma tecnologia, como o TensorFlow, uma API para machine learning, que foi recentemente aberto para o público.

O Android é outro grande produto do Google, assim como a linguagem Go, que é usada no App Engine e, finalmente, o Kubernetes (Sistema de orquestração de containters).

Um pouco da história

A primeira onda

Todos lembram quando começou o interesse por computadores e a dificuldade que era adquirir um exemplar. Imagina montar um datacenter?

Nesta época, era comum “alugar” tempo de mainframe, que eram de universidades ou grandes empresas. PCs vieram e, como eram mais baratos, começou a ser possível unir uma porção deles. Com isso, as redes ficaram maiores e mais difíceis de manter e atualizar — foi quando surgiram as empresas de co-location.

A partir daí, você comprava as máquinas e o software e alugava um espaço em um lugar específico para esse fim. Estas empresas conseguiam garantir uma maior tolerância à falha e performance de rede porque eram escaláveis. De qualquer forma, você ainda era o dono das máquinas e software.

A segunda onda

Uma nova e promissora tecnologia surgiu — a virtualização. Ela possibilitou a utilização de múltiplos sistemas operacionais rodando ao mesmo tempo em uma única máquina.

Empresas como a Amazon começaram a alugar espaço de seu hardware e o Cloud Computing nasceu. Esta, definitivamente, é a segunda onda e acreditamos estar nela nos dias de hoje. Você não é o dono das máquinas, você é o administrador e paga pelo aluguel delas.

A terceira onda

O Google tem a visão de uma nova onda no Cloud Computing, aquela em que os serviços são totalmente administrados pelo provedor e seus clientes focam apenas em criar suas aplicações e aplicar suas regras de negócio. Na verdade, já existem diversos serviços com este propósito e a onda já tem um nome: NoOps.

O Google Cloud Platform tem um leque enorme de produtos e serviços, que podem ser amplamente categorizados como compute, storage, big data e machine learning.

Links úteis:

• Porque o GCP?

• Filosofia de preços

• Data Centers

• Overview do Produto GCP

• Soluções do GCP

LAB

Clique neste link para realizar. Não deixe de executar todos os passos do lab, ele é incremental e nos ensina muita coisa também.

No próximo post, vamos colocar a mão na massa e começar a entender as estruturas do Google Cloud Platform CP e seus projetos. Até lá!

Qual a relevância do NOC Cloud para o seu negócio?

O NOC Cloud – Centro de Operações de Rede para Cloud –, centraliza o monitoramento e operações de um ou mais ambientes de rede de TI. Basicamente, ajuda evitar a desvalorização de sua empresa e aumentar a qualidade de seus serviços, já que impossibilita que seu cliente final experiência problemas na infraestrutura, uma vez que o problema é detectado prematuramente pela equipe responsável pelo monitoramento.